Contexte

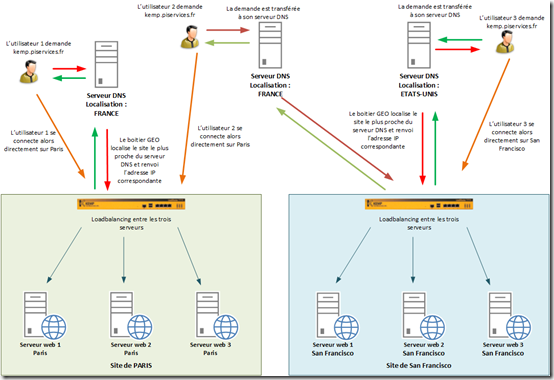

Ce billet fait suite à mon premier post sur l’option GEO des boitiers KEMP. Dans le billet précèdent j’expliquai comment faire pour contourner l’impossibilité de mettre des emplacements personnalisées sur les boitiers KEMP.

Hors depuis la version 7-1-20a, l’option GEO possède une nouvelle fonctionnalité : le Custom Location !

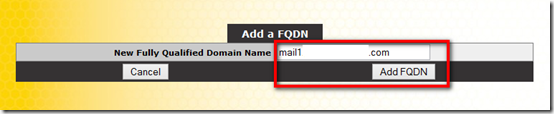

Mise en place

Avant la mise en place des custom location, il est intéressant de mettre à jour la base de données des localisations. Pour se faire connectez-vous au site https://support.kemptechnologies.com puis dans la partie Downloads et Other Downloads téléchargez la dernière version.

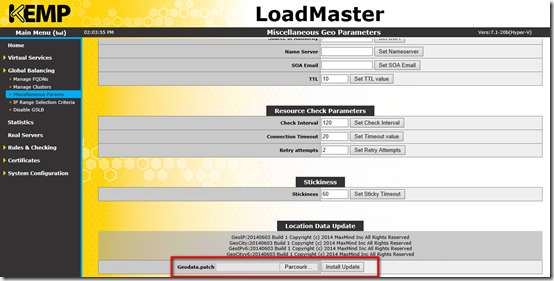

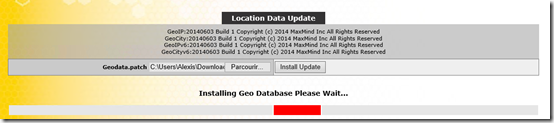

Connectez-vous à l’interface web du KEMP puis dans la partie Global Balancing, cliquez sur Miscellaneous Params. Dans Location Data Update cliquez sur Parcourir… sélectionnez le fichier d’update et cliquez sur Install Update.

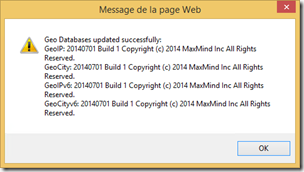

Un message vous avertit une fois la mise à jour terminée.

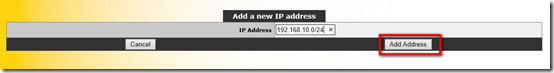

Pour créer une Custom Location vous devez dans un premier temps indiquez une IP (ou un range d’IP). Pour cela dans la partie Global Balancing, allez dans IP Range Selection Criteria et ajoutez une IP en cliquant sur Add IP.

Indiquez l’IP (suivi du /32) ou un range d’IP (suivi de son masque sous la forme /XX) et cliquez sur Add Address.

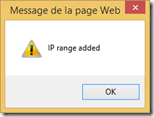

Un message apparait pour valider l’ajout.

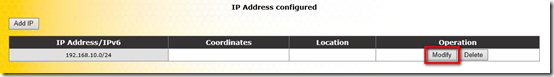

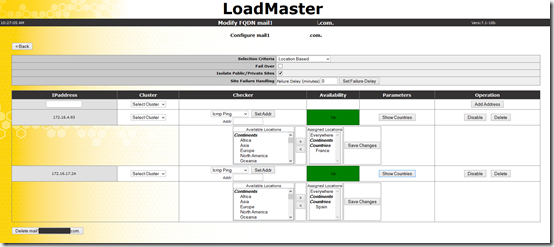

Cliquez ensuite sur Modify puis cochez la case Add Custom Location.

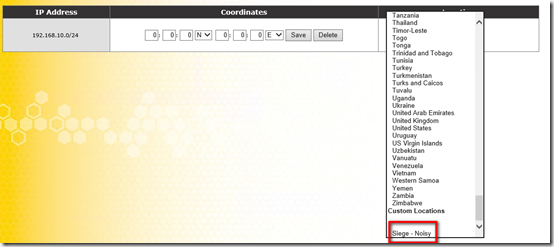

Indiquez un nom à la localisation puis sélectionnez-la dans la liste déroulante.

Cliquez sur <- Back pour valider et revenir à la page précédente.

Ce range d’IP appartient désormais à la localisation Siege – Noisy.

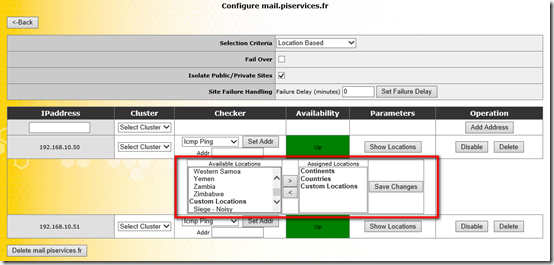

Il est désormais possible d’affecter cette localisation à une IP dans la partie Manage FQDNs.